Filtry za linki wychodzące (case study)

Artykuły3 kwietnia 2014

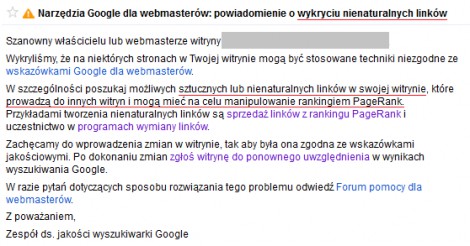

Jednym z powodów, przez które ekipa SQT (Search Quality Team) nakłada filtry na strony, są nienaturalne linki wychodzące. Są to filtry ręczne, których nałożenie wiąże się z pojawieniem się informacji o karze w narzędziach dla webmasterów w zakładce Ruch związany z wyszukiwaniem -> Działania ręczne oraz z otrzymaniem komunikatu w sekcji Wiadomości. Warto zatem skonfigurować ustawienia GWT w taki sposób, aby automatycznie otrzymywać powiadomienia mailowe o każdym takim komunikacie.

Case study, który przedstawię, dotyczy dość starej sytuacji jeszcze z czasów, zanim wprowadzono zakładkę Działania ręczne. Dotyczy on jednak problemu, z którymi cały czas możemy się spotykać.

Opis strony:

Informacyjny serwis o tematyce zdrowotnej, który został stworzony głównie na potrzeby pozycjonowania. W momencie wystąpienia problemów z filtrem, opublikowanych było ponad 100 artykułów, z czego większość była unikalna, a 7 zostało przedrukowanych z innego serwisu - aby nie wystąpił problem z duplicate content, artykuły te miały ustawiony metatag noindex. Domena istniała od 2005 r. i od początku dotyczyła tematyki zdrowotnej, ale została przeze mnie zakupiona dopiero w 2009 r. Od początku była podpięta pod usługi Google (GWT i Google Analytics).

Linki na stronie znajdowały się w kilku miejscach i prowadziły do stron o zbliżonej tematyce:

- w sidebarze (wyświetlane site-wide) - 2 linki graficzne + 5 linków tekstowych;

- w treści artykułów - głównie 7 przedrukowanych artykułów, w których linki miały postać anchorów z pozycjonowanymi słowami kluczowymi;

- w osobnej zakładce - 1 link graficzny;

- w stopce - 2 linki do autorów szablonu.

Opis sytuacji:

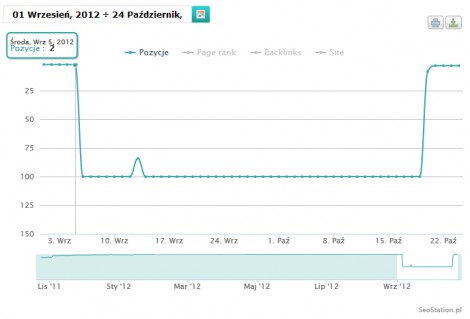

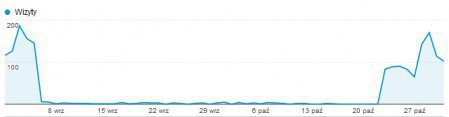

- 6 września 2012 r. - spadek pozycji poza top 100 (widok poniżej) skutkujący spadkiem ruchu organicznego (kolejny obrazek);

- 7 września 2012 r. - otrzymanie powiadomienia o wykryciu nienaturalnych linków wychodzących

- 9 września 2012 r. - usunięcie wszystkich linków z sidebara oraz osobnej podstrony i wysłanie zgłoszenia ponownego rozpatrzenia;

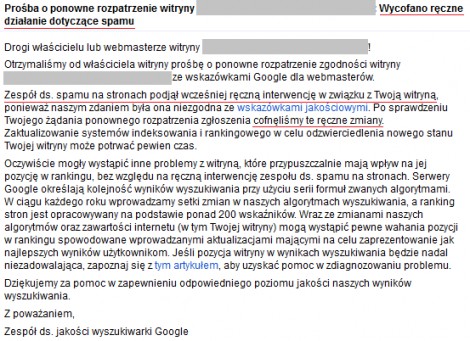

- 21 września 2012 r. - otrzymanie powiadomienia o odrzucenia zgłoszenia ponownego rozpatrzenia;

- 19 października 2012 r. - odszukanie przedrukowanych artykułów z linkami w treści i ustawienie nofollow oraz wysłanie zgłoszenia ponownego rozpatrzenia. Wcześniej artykuły z przedruku miały ustawiony metatag noindex, co nie pozwalało na indeksację ich zawartości, ale ze względu na domyślne ustawienie follow dla linków, pozwalało na zliczanie linków;

- 20 października 2012 r. - powrót na stare pozycje, przy czym dzień wcześniej otrzymałam komunikat o przyjęciu zgłoszenia (bez informacji o jego rezultacie);

- 23 października 2012 r. - otrzymanie powiadomienia o wycofaniu kary.

W późniejszym czasie linki w sidebarze zostały przywrócone, podobnie jak linki w niektórych artykułach - za wyjątkiem tych z przedruku. Nie powodowało to nakładania kolejnych kar ani gwałtownych spadków pozycji, aczkolwiek zmiany w ruchu organicznym miały tendencję spadkową.

Podsumowanie:

W przypadku otrzymania ręcznego filtra za linki wychodzące, można je albo całkowicie usunąć, albo przynajmniej na jakiś czas nałożyć na nie nofollow. W takim przypadku nie powinno być ryzyka, że zgłoszenie ponownego rozpatrzenia zostanie odrzucone. Po wycofaniu kary można przywrócić część linków - wiąże się to oczywiście z pewnym ryzykiem przywrócenia kary, ale jak widać na powyższym przykładzie, problemy tego typu nie muszą się powtórzyć jeśli wykluczy się te linki, które były głównym powodem kary - czyli w tym przypadku linki z treści artykułów opatrzone anchorami w postaci słów kluczowych i kierujące do stron słabej jakości.

Marta Gryszko

Marta Gryszko

Stare komentarze: 8

Ciekawi mi mnie jak ta sytuacja przekładała się na strony docelowe, do których prowadziły linki z Twojej strony...? Czy masz jakieś informacje na ten temat? Może któraś ze stron, do której prowadziły linki była Twoja i miałaś też dostęp do jej panelu GWT. Ciekawe czy informacja związana z filtrem za linki wychodzące, pokrywa się jednocześnie z informacją za linki przychodzące.

Rozumiem, że kiedy wszystkie linki na mojej stronie są nofollow to jestem bezpieczny?

Sebastian, miałam część z tych stron podpiętych pod GWT i nie wiązało się to z powiadomieniami ani spadkami ich pozycji - ale to były strony, do których linki wyświetlałam w sidebarze i które później przywróciłam. Dlatego moim zdaniem problemy były tylko ze stronami podlinkowanymi z artykułów do przedruku, bo jakość była niezbyt wysoka, a same linki były mocno zoptymalizowane pod kątem SEO.

Bartek, tak. Nofollow zabezpiecza przed takimi karami, chociaż z tego co Matt któregoś razu mówił, można dostać karę z drugiej strony, tj. za nienaturalne linki przychodzące, jeśli masowo były zdobywane linki nofollow. Ale wydaje mi się, że w praktyce ciężko jest się spotkać z takimi karami.

Czy ktoś z was ma doświadczenie na Wordpressie? Ostatnio obserwuję takie strony w formacie:

mojastrona.wordpress.com, i zauważyłem że na nie nie są zakładane filtry.

Blogerzy wstawiają sobie setki linków wychodzących, komentują inne blogi gdzie się da i Google im na to pozwala. Jak tylko wykupisz swoją domenę i zaczniesz robić to samo, od razu masz filtra.

@Remigiusz

To proste - algo nie potrafi odróżnić spamu od nie spamu i potrzebna jest ręczna moderacja. W przypadku wordpress.com taką moderację przeprowadzają właściciele serwisu i bywa, że blokują blogi łamiące standardy. Inne przykłady ręcznej moderacji ro disavov. Stawiasz człowieka pod ścianą (obojętnie czy słusznie czy nie) i tenże musi dokonać ręcznej moderacji stron - potem zgłasza i na tacy mają co i jak. Flagują i kółko się kręci.

Dzięki Zeki za odpowiedź. Tak mi się wydaje że ten terror z banowaniem stron ze strony Google opiera się na kasie. Przecież logiczne, że jeśli ktoś ma bloga na darmowym serwerze, nie jest firmą i może robić co mu się podoba. Jak tylko masz stronę firmową, wtedy Google chce od ciebie pieniądze za reklamę, dlatego utrudnia życie. Może nadeszły czasy żeby firmowe strony budować na darmowych serwerach, takich jak Wordpress.

Stary kotlet odgrzewany z Twojego blogu Lexy:

http://www.lexy.com.pl/blog/filtr-za-linki-z-niezaindeksowanych-stron.html

Nie wiem czy w obecnym kształcie algorytmu takie zdarzenia miałyby jeszcze miejsce. Daty są z 2012 roku - Litości...

Daty nie mają tu znaczenia, bo jest to rodzaj kary cały czas aktualny.