Relacja z hangoutu na temat duplicate content [6 października 2015]

Relacje8 października 2015

Praktycznie każda strona boryka się z jakimiś problemami z powielaniem treści, czy to na zasadzie przypadkowego udostępniania tej samej treści bądź jej fragmentów pod wieloma adresami, czy w postaci podstron tagów, osobnych wersji na komórki czy wersji do druku itp. Oprócz wspomnianych problemów, część stron publikuje informacje prasowe bądź treść opracowaną przez użytkowników, która może występować także na innych stronach.

Wielu początkujących webmasterów zastanawia się, czy Google uważa tłumaczone materiały za kopie. Padają nawet pytania o to, czy Google rozpozna tekst tłumaczony automatycznym translatorem i uzna go za kopię. Według Johna Muellera – nie. Podobnie problemu nie stanowią powielone opisy w sekcji META, ponieważ pod tym względem liczy się główna zawartość serwisu. Mimo wszystko wyszukując podstrony z tymi samymi tytułami bądź opisami (można to zrobić m.in. w Search Console), można w łatwy i szybki sposób trafić na powielone materiały.

Czy Google stosuje kary za DC i jak sobie radzić z problemem powielonej treści? Odpowiedzi na te pytania znajdują się w poniższej relacji z hangoutu z Johnem Muellerem, który odbył się 6 października. Tekst zawiera również nasze komentarze dotyczące omawianych w nim kwestii.

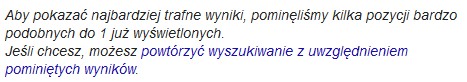

John wielokrotnie powtarzał, że Google nie stosuje kar za powielanie treści. Pamiętajmy jednak o tym, że Google nigdy nie mówi o karach w kontekście spadków wywołanych zmianami w algorytmie (tym samym stosowanie określenia „kary algorytmiczne” jest nie do końca poprawne, mimo że przyjęte w potocznym języku). O karach mowa jest wyłącznie w odniesieniu do działań ręcznych, mimo że dla nas istotny jest efekt, a ten z kolei jest zbliżony do kary. Wkońcu DC może spowodować wyświetlanie mniejszej ilości podstron z naszego serwisu dla konkretnego zapytania, w rezultacie czego zobaczymy poniższą informację:

Dopiero po kliknięciu „powtórzyć wyszukiwanie...” znajdziemy wszystkie zaindeksowane wyniki łącznie z tymi uznanymi za kopie. Dawniej używało się określenia supplemental index (tłum. wyniki uzupełniające/indeks uzupełniający) do wyników, które uda się w ten sposób „odkryć”.

Warto w tym miejscu nadmienić, że nie zawsze Google rozpozna prawidłowo, który z wyników jest bardziej trafny i powinien zostać wyświetlony. A to już może spowodować, że w przypadku wyboru innej podstrony niż ta, którą staraliśmy się najlepiej zoptymalizować pod daną frazę, wyświetlony zostanie wynik zajmujący znacznie niższą pozycję.

Wyjątkiem od opisanych powyżej sytuacji jest celowe, automatyczne pobieranie treści z innych stron i tym samym doprowadzenie do efektu DC. Te są traktowane jak zwykły spam i tym samym są karane.

To, co może zainteresować wielu z nas, to temat powielonej treści w sklepach internetowych. Chodzi mianowicie o wykorzystywanie opisów producentów przez wiele sklepów, co jest sytuacją w pełni naturalną i powszechnie występującą. John zaleca, aby w takiej sytuacjii zadbać o tzw. wartość dodaną w postaci unikalnych treści. To ma być coś, co wyróżnia serwis i sprawia, że warto wyświetlić go użytkownikom wyszukiwarki.

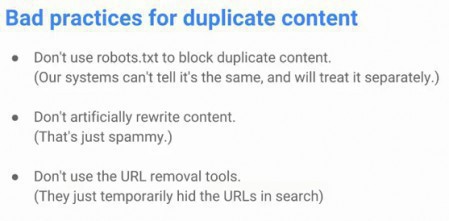

Czego nie należy robić, aby wyeliminować problem DC?

Wg Johna nie należy wykorzystywać pliku robots.txt w celu zablokowania dostępu do podstron z powieloną treścią. Jeśli Googlebot nie będzie miał dostępu do zablokowanych zasobów, nie będzie w stanie rozpoznać, że blokowany jest zasób skopiowany.

Kolejna sprawa to to, aby nie starać się na siłę przeredagowywać tekstów, ponieważ może to zostać odebrane jako spam. Z drugiej strony dobrze wiemy, że czasem warto „przepisać” treść przynajmniej na najważniejszych podstronach i opisy te wcale nie muszą wyglądać sztucznie.

W ostatnim punkcie John odradza usuwanie duplikatów poprzez narzędzie do usuwania wyników z Google dostępne z poziomu Search Console. Twierdzi on, że wspomniane narzędzie służy do tymczasowego usunięcia wyniku z indeksu i tym samym nie przyniesie oczekiwanego, stałego rezultatu.

Co zatem należy robić?

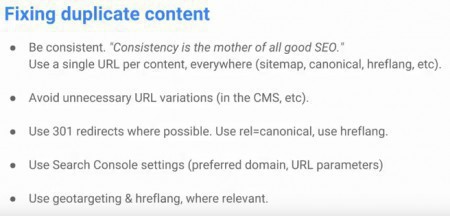

W skrócie, należy:

-

konsekwentnie trzymać się jednego, wybranego formatu adresu URL;

-

unikać stosowania różnego rodzaju odmian adresów URL, w szczególności tych wynikających ze stosowania popularnych CMSów;

-

tam, gdzie to możliwe, stosować przekierowania 301, ewentualnie rel=”canonical” lub hreflang (dla różnych wersji językowych);

-

zadbać o ustawienie preferowanej domeny i parametrów w Search Console;

-

w razie potrzeby używać atrybutu hreflang (strony w tym samym języku mogą być kierowane do użytkowników z różnych krajów i nie musi to powodować konieczności wybrania przez Google tylko jednej z tych wersji do wyświetlania w swoich wynikach).

Po niespełna 20-minutowej prezentacji Johna, nadszedł czas na sesję pytań i odpowiedzi. Poniżej zamieszczamy najciekawsze informacje z tej części spotkania:

-

stosowanie aliasów kategorii w adresach URL – padło pytanie o to, czy warto stosować w adresach URL aliasy kategorii, skoro w przypadku dodania tego samego produktu do wielu kategorii, dochodzi do sytuacji, w której ta sama zawartość wyświetla się pod wieloma adresami. John zaleca stosowanie w takiej sytuacji atrybutu rel=”canonical” i podkreśla przy tym, że Google bierze pod uwagę wiele czynników podczas podejmowania decyzji co do tego, który z adresów wyświetlić;

-

procent powielonej treści – nie ma z góry określonego pułapu, po przekroczeniu którego treść jest uznawana za powieloną. Bez względu na to, czy jest to krótki fragment, czy połowa artykułu, liczy się wiele sygnałów i tym samym Google może się zdecydować na wyświetlanie na wysokich pozycjach wielu wyników z częściowo pokrywającą się treścią, jeśli mają one tzw. wartość dodaną;

-

lokalizacja powielonej treści – nie ma znaczenia, czy powielony fragment treści znajduje się powyżej czy poniżej linii przewijania;

-

osobne podstrony dla różnych rozmiarów – to kolejny problem sklepów internetowych. Nie dość tego, że większość z nich stosuje opisy producentów, to jeszcze pojawia się sytuacja, w której różne rozmiary bądź kolory produktów trafiają na osobne adresy URL. Również w tym przypadku John zalecił zastosowanie rel=”canonical” ze wskazaniem głównej wersji, bądź też zadbanie o taką zawartość na podstronach różnych rozmiarów, dzięki której będą się one czymś wyróżniały i będą zróżnicowane;

-

usuwanie z indeksu stron z powieloną treścią – zalecane jest zastosowanie przekierowania 301 lub użycie rel=”canonical”, a nie kodów 404 lub 50*. Kody te powodują utracenie wszelkich dodatkowych informacji odnośnie usuwanych w ten sposób podstron, w tym informacji o kierujących do nich linkach, z kolei 301 lub rel=”canonical” zachowują wszelkie sygnały tego typu;

-

postępowanie w przypadku wykrycia kary „czysty spam” (z ang. pure spam) – w przypadku zakupienia domeny z historią może dojść do sytuacji, w której pracownicy Google uznają stronę za „czysty spam” i oznaczą ją w ten sposób w Search Console. Jeśli wykorzysta się tą samą zawartość, nie będzie podstaw do wycofania ręcznych działań. Jeśli jednak treść zostanie zmieniona, kara powinna zostać wycofana;

-

data pierwszej publikacji materiału – padło pytanie o to, czy Google uwzględnia datę pierwszej publikacji materiału podczas ustalania, który z wyników zawiera materiał oryginalny. John przyznał, że problemem jest to, iż spamerzy są w stanie pobrać cudzą treść i zaindeksować ją wcześniej niż oryginalna strona, która może być dużo mniej popularnna. Google nie może zatem polegać w 100% na tym sygnale.

Podsumowując, najważniejsze jest zadbanie o to, aby w miarę możliwości treść była dostępna wyłącznie pod jednym adresem i aby z różnych kanałów zawsze kierować tylko do niego. Jeśli wystąpi problem z duplicate content, może dojść do sytuacji, w której Google błędnie uzna kopię lub artykuł mniej trafny (w oczach właściciela strony) i tym samym nasz materiał straci na widoczności w wynikach wyszukiwania. Są jednak sytuacje, w których rozwiązania technologiczne zakładają występowanie tej samej treści na różnych podstronach – wtedy należy zadbać o tzw. wartość dodaną lub po prostu „scalić” materiały przez zastosowanie rel=”canonical”, czyli tagu, który wskazuje na oryginalną czy też główną treść.

Na zakończenie zachęcamy do obejrzenia pełnego nagrania i dodawania komentarzy:

Administracja SeoStation

Administracja SeoStation

Stare komentarze: 2

A co w momencie, gdy strona publikuje materiały przesłane przez agencje PR-owe? Tego typu materiały wysyłane zostają najczęściej do kilku/kilkunastu odbiorców i są umieszczane na stronach bez zmian w tytule, bądź treści. W takim przypadku chyba lepiej w meta tagach umieścić noindex niż kombinować z canonicalami, bo często nie da się wskazać tekstu źródłowego a konkurencji nikt nie będzie likować...

Ja akurat staram się unikać publikowania informacji prasowych u siebie. Zazwyczaj na swojej stronie publikuję raport (np. z wyników ankiety) i odsyłam do niego z treści informacji prasowych publikowanych w zewnętrznych źródłach.

Ale gdyby zależało mi na ich publikowaniu i nie stanowiłyby one głównej treści serwisu, to nie wstawiałabym noindex. Po prostu nie nastawiałabym się na to, że akurat ten materiał, który został opublikowany oryginalnie, będzie zajmował wysokie pozycje.